|

|

在东方财富看资讯行情,选东方财富证券一站式开户交易

/ w; m3 ^ z6 O- h) G 随着AI计算对内存需求不断扩大,全球存储技术创新也进入“加速期”。

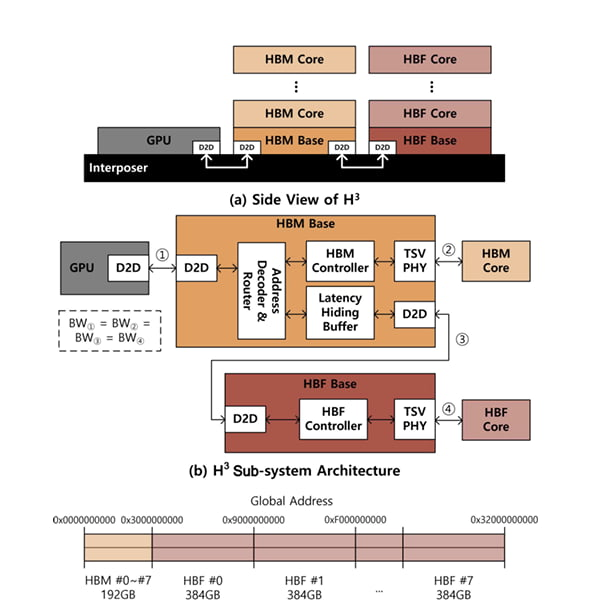

& t% b8 ~0 ~0 P- D! p5 Y$ a: F6 Q3 E- \ 据韩国经济日报报道,SK海力士近日在IEEE(电气与电子工程师协会)全球半导体大会上发表论文,提出了一种全新的存储架构。据悉,该架构名为“H³(hybrid semiconductor structure)”,同时采用了HBM和HBF两种技术。; a4 b ?$ J J6 z: z' K

在SK海力士设计的仿真实验中,H³架构将HBM和HBF显存并置于GPU旁,由GPU负责计算。该公司将8个HBM3E和8个HBF置于英伟达Blackwell GPU旁,结果显示,与单独使用HBM相比,这种配置可以将每瓦性能提升高达2.69倍。% `* R( s5 D; z" E

图源:SK海力士- R% I/ u1 a+ ]# h; F2 }0 Y

图源:SK海力士- R% I/ u1 a+ ]# h; F2 }0 Y

实验结果显示,H³架构在AI推理领域尤其具有优势。推理的核心是键值缓存 (KV cache),它用于临时存储数据,以理解 AI 服务与用户之间交互的流程和“上下文”。然而,随着 AI 性能的提升,KV缓存容量不断增长,以至于HBM和GPU逐渐应接不暇。

* g" l7 x- K2 q9 g5 y, N* |; \$ g 因此,HBF被视作上述架构的核心。与堆叠DRAM芯片的HBM类似,HBF通过堆叠NAND闪存而制成。被称作“HBM之父”的韩国科学技术院(KAIST)教授金正浩类比道,HBM与HBF就好比书房与图书馆。前者容量虽小,但使用起来方便;后者容量更大,但也意味着延迟更高。

T- j# K3 V- l$ _; \$ E' K$ Y 通过在HBF中存储KV缓存,GPU和HBM可以减轻存储KV缓存的负担,从而专注于它们在高速计算和创建新数据方面的优势。SK海力士模拟了HBF处理高达1000万个令牌的海量键值缓存的场景,结果表明,与仅使用HBM的配置相比,该系统处理并发查询的能力提升了高达18.8倍。以前需要32个GPU才能完成的工作负载,现在只需两个GPU即可完成。9 d% s) a! R- E

从产业层面来看,SK海力士、三星、闪迪等均在推进HBF技术研发。SK海力士计划最早于今年推出HBF1(第一代产品)样品,该产品预计采用16层NAND闪存堆叠而成。三星电子和闪迪则计划最快在2027年底或2028年初将HBF技术应用于英伟达、AMD和谷歌的实际产品中。

4 I5 q9 D/ v9 R/ C3 L& L; K 广发证券认为,当前大模型的参数规模已经达到万亿级别,上下文长度普遍超过128K,HBM的容量已难以满足AI大模型对于内存容量的要求。在研的HBF存储容量有望达到现有HBM的8至16倍,有望将GPU的存储容量扩展至4TB,或成为满足AI大模型内存容量要求的最佳方案。6 |' A) G% t+ i* j% w

东方证券表示,利基存储不仅是存量市场,更是增量市场,AI需求有望为利基存储打开增量空间。SLC NAND有望应用于AI SSD产品,以高效处理AI推理中的数据;SLC NAND未来也可能应用在HBF(高带宽闪存)中。利基存储产能持续被主流存储挤压,涨价有望持续。, t9 G2 @ B8 W+ S% f1 G/ C

全新妙想投研助理,立即体验

' N; S8 t% W, x6 k' y& b(文章来源:科创板日报) |

|