|

|

) T6 v/ c u; [9 G2 L* _# A# ~

) T6 v/ c u; [9 G2 L* _# A# ~

编辑:定慧 好困" u$ R) w3 `" _7 {

【新智元导读】DeepSeek开源DeepSeek-OCR2,引入了全新的DeepEncoder V2视觉编码器。该架构打破了传统模型按固定顺序(从左上到右下)扫描图像的限制,转而模仿人类视觉的「因果流(Causal Flow)」逻辑。5 K( M- n o# U8 @

DeepSeek又双叒叕更新了!7 {4 E }+ x- K# t" h6 h& S

这次是DeepSeek-OCR模型的重磅升级:DeepSeek-OCR2。+ |( j# f+ M# E( d7 p

1 g0 ~6 ^/ j" [% {( b+ |

1 g0 ~6 ^/ j" [% {( b+ |

还记得上一代DeepSeek-OCR吗?那个用视觉方式压缩一切的模型。

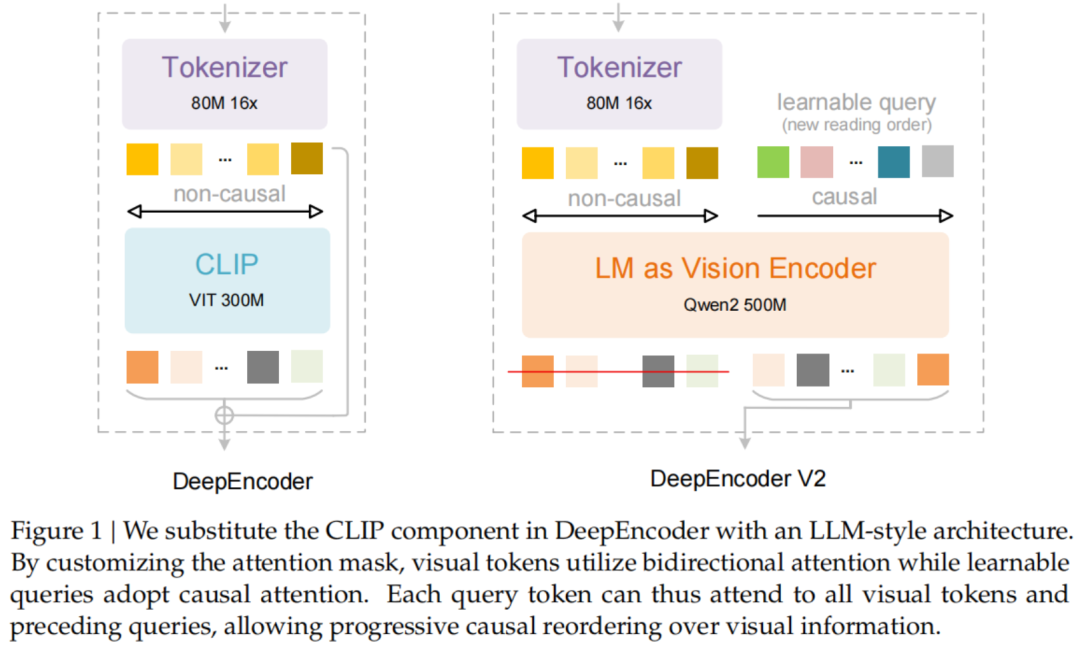

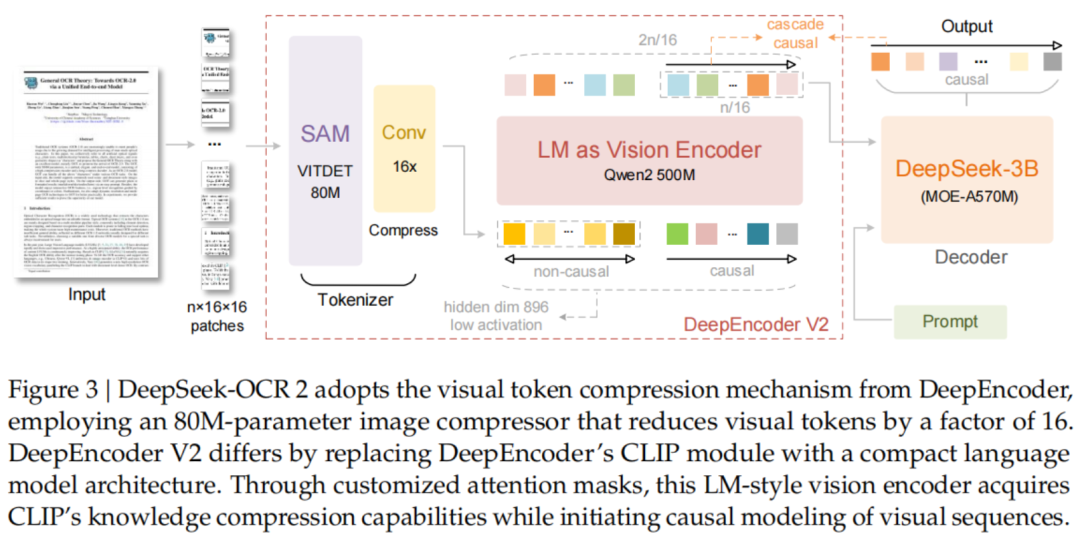

5 n4 M' k# u3 \' E2 o这一次,DeepSeek更进一步,对视觉编码器下手了,提出了一种全新的DeepEncoder V2架构,实现了视觉编码从「固定扫描」向「语义推理」的范式转变!

& x. v% Z, S: k' b

/ K" `, D, `4 Q! L3 [1 c" y" I

/ K" `, D, `4 Q! L3 [1 c" y" I

DeepSeek-OCR2不仅能像人类一样按逻辑顺序阅读复杂文档,还在多项基准测试中刷新了SOTA。 J N2 V1 s5 |1 r, `: f. p

当然,按照DeepSeek的惯例,Paper、Code、Model全开源!

/ G ^8 E5 M5 c: S8 Y$ }

- O; [/ m. H; I0 p: fDeepSeek-OCR2的核心创新在于通过DeepEncoder V2,赋予了模型因果推理能力(Causal Reasoning)。% A& F. t( k1 O2 Z g5 ~7 g H

这就像是给机器装上了「人类的阅读逻辑」,让AI不再只是死板地从左上到右下扫描图像,而是能根据内容语义灵活调整阅读顺序。7 z' x) u# @# c; F

DeepSeek-OCR2/ r% f% ^2 a) |, |

视觉因果流

, [0 ] N" v$ k fDeepSeek在论文中指出,传统的视觉语言模型(VLM)通常采用光栅扫描(Raster-Scan)顺序处理图像,即固定地从左到右、从上到下。; y8 j# c* R- U1 G4 k V0 ], `- o

这种方式强行将2D图像拍扁成1D序列,忽略了图像内部的语义结构。% M, e. x+ t I! _+ G% M5 q

# i& Y! m9 |2 T; w0 l这显然与人类的视觉习惯背道而驰。4 L* F3 q# S' D9 `; ?5 |. c4 d$ Q

人类在看图或阅读文档时,目光是随着逻辑流动的:先看标题,再看正文,遇到表格会按列或按行扫视,遇到分栏会自动跳跃。' p- V2 R, ?$ K y0 z

为了解决这个问题,DeepSeek-OCR2引入了DeepEncoder V2。

C1 h1 g, ]+ E( P' ^9 g' h! g它最大的特点是用一个轻量级的大语言模型(Qwen2-0.5B)替换了原本的CLIP编码器,并设计了一种独特的「因果流查询」(Causal Flow Query)机制。2 h4 X9 N+ j, k) E6 K

DeepEncoder V2架构详解

1 p' P9 h+ _' m2 c- e H, oDeepEncoder V2主要由两部分组成:

) s5 w2 { h. y4 l) [; e1. 视觉分词器(Vision Tokenizer)/ M* Y( ]' Z) v/ k8 D

沿用了SAM-base(80M参数)加卷积层的设计,将图像转换为视觉Token。

# ?! V, p6 k& i/ R/ [0 q! s$ r7 Q

9 ~0 ?) f% l! H, l/ L2. 作为视觉编码器的LLM$ \3 o: m: W& R2 ]6 g

这里DeepSeek使用了一个Qwen2-0.5B模型。6 c; Y1 b& b/ A) K* }

它不仅处理视觉Token,还引入了一组可学习的「查询Token」(Query Tokens)。: F' o) y! V6 D. m

# d* v8 K2 M, B9 Z

# d* v8 K2 M, B9 Z

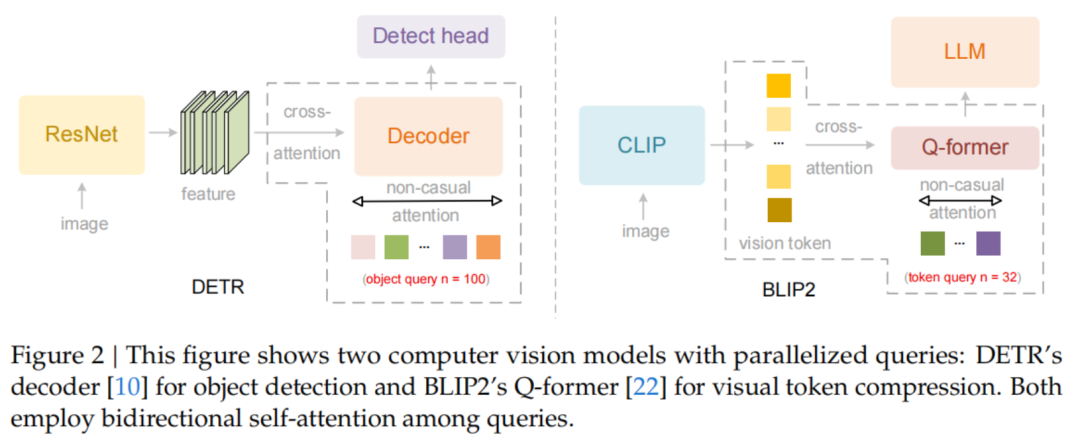

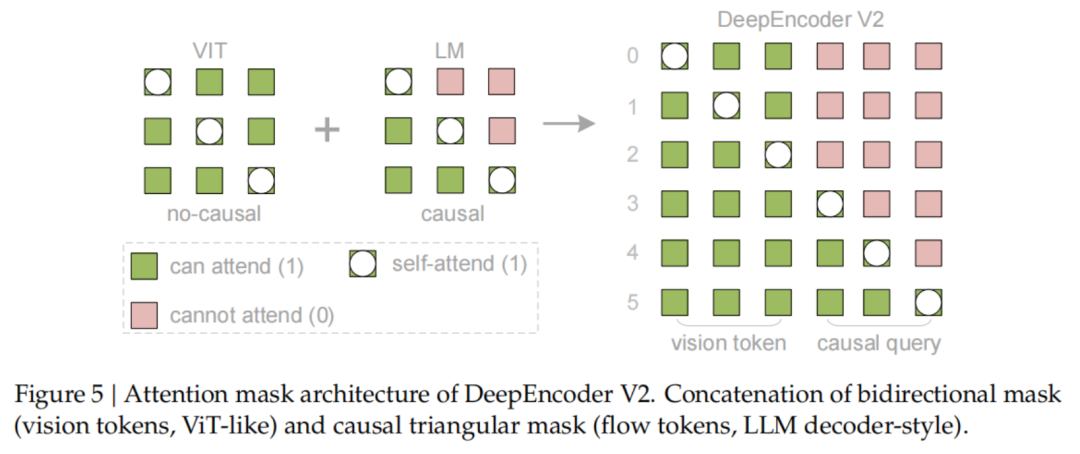

关键的创新点在于注意力掩码(Attention Mask)的设计:

: q% S. E8 d' H( t0 S( J! `

3 r; [" T6 r: K2 B& Z视觉Token之间采用双向注意力(Bidirectional Attention),保持全局感知能力,类似于ViT。$ P: |* y1 f) h& R, ^% `0 ^

而查询Token则采用因果注意力(Causal Attention),每一个查询Token只能看到它之前的Token。3 e9 F4 ]0 K0 Q5 l4 e

通过这种设计,DeepEncoder V2实现了两级级联的因果推理:1 J% a+ e, a1 O6 {- {

编码器通过可学习的查询对视觉Token进行语义重排,随后的LLM解码器则在这个有序序列上进行自回归推理。1 n( Y5 p( r( w- T! H- [* A0 ^

这意味着,DeepSeek-OCR2在编码阶段就已经把图像里的信息「理顺」了,而不是一股脑地扔给解码器。

% ?5 r, \/ l) n1 X JToken更少,精度更高

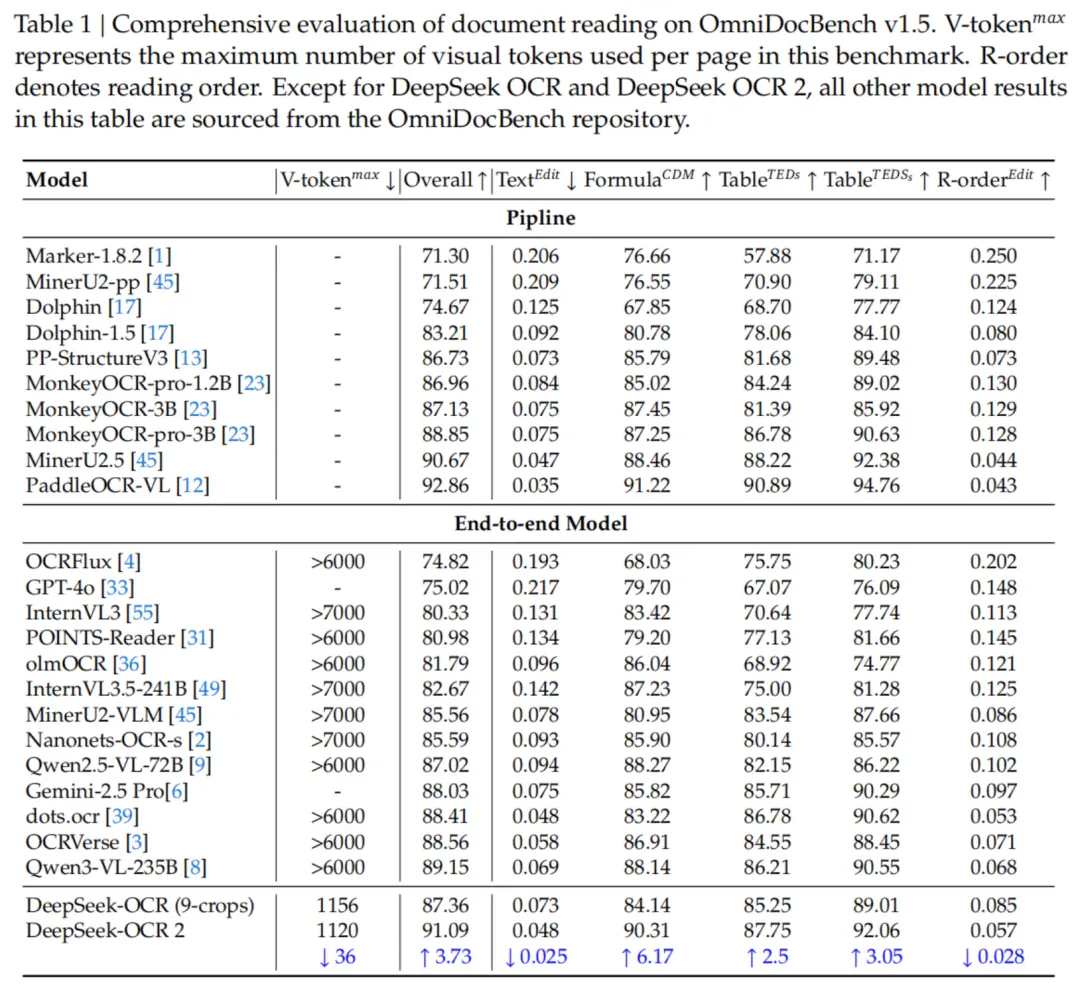

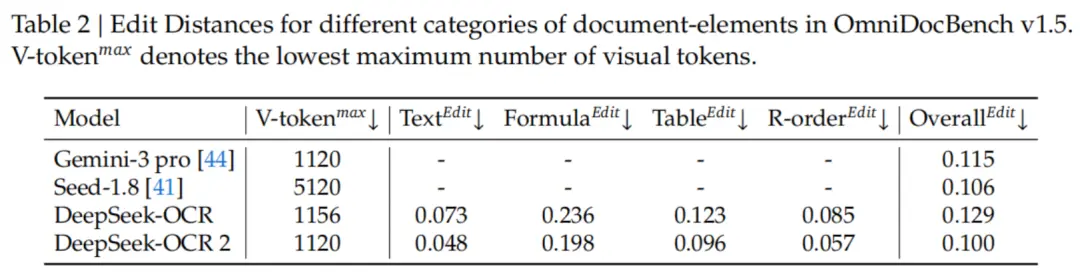

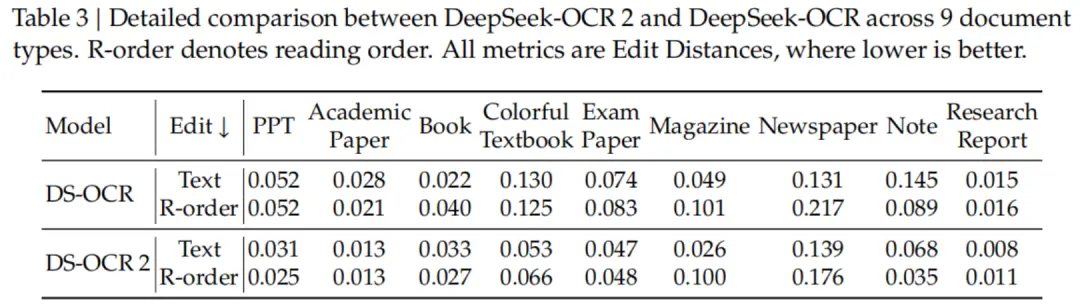

1 \1 ?8 f x& w D; g+ a! _实验数据显示,DeepSeek-OCR2在保持极高压缩率的同时,性能显著提升。

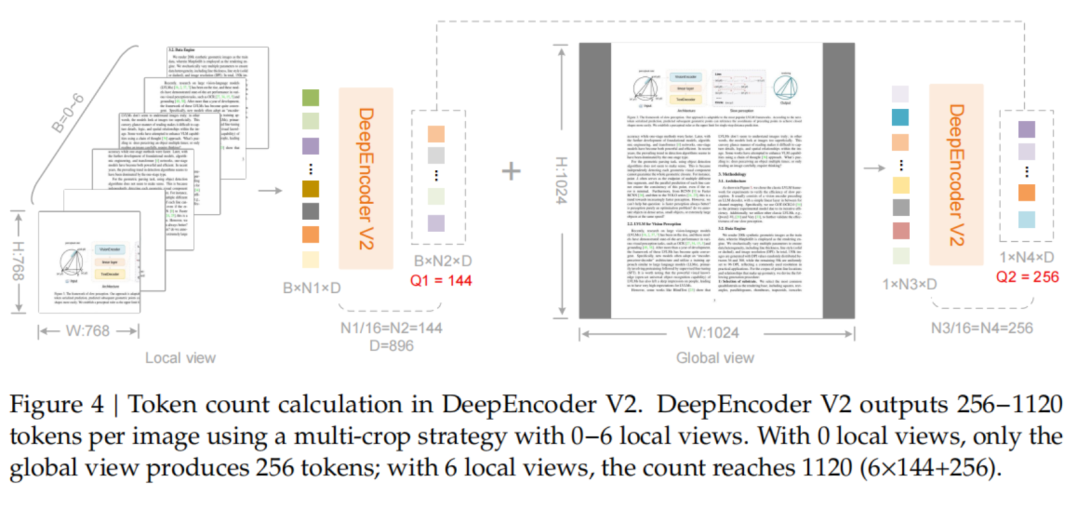

2 z- H2 H$ j; O$ O3 r在OmniDocBench v1.5基准测试中,DeepSeek-OCR2在使用最少视觉Token(仅256-1120个)的情况下,综合得分高达91.09%,相比前代提升了3.73%。

, S1 M9 s" h, ?) ]! S

6 ?9 u" g9 c; b8 s& y9 X特别值得一提的是,在阅读顺序(R-order)的编辑距离(Edit Distance)指标上,DeepSeek-OCR2从前代的0.085显著降低到了0.057。

?) g6 j$ ]# b5 n这直接证明了新模型在处理复杂版面时,逻辑性更强,更懂「阅读顺序」。

8 V) G* p8 h8 s$ d! f在和Gemini-3 Pro等闭源强模型的对比中,DeepSeek-OCR2也丝毫不落下风。& M0 K# a, B8 d, Q# _$ T

在均使用约1120个视觉Token的情况下,DeepSeek-OCR2的文档解析编辑距离(0.100)优于Gemini-3 Pro(0.115)。

& Z4 q3 x% i: {5 }+ {* G3 \

/ t9 q( }! A, T( s

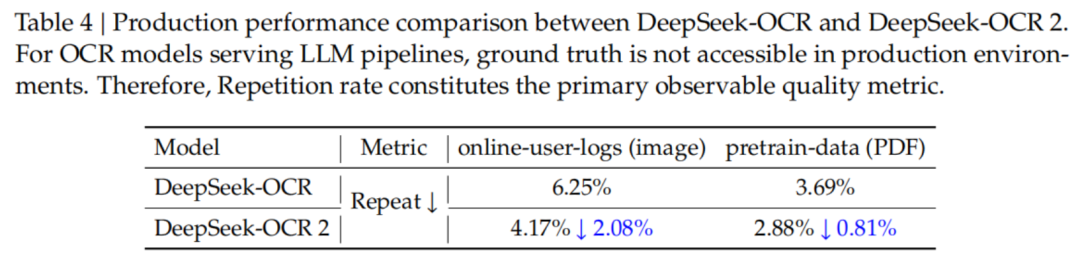

8 a$ l0 C% L9 i8 p8 o不仅是刷榜,DeepSeek-OCR2在实际生产环境中也非常能打。

# g+ k4 a0 j4 U- v. M( q- ?9 ~DeepSeek披露,在处理在线用户日志图像时,OCR结果的重复率从6.25%降到了4.17%;在PDF数据生产场景中,重复率从3.69%降到了2.88%。' |0 E+ E3 H0 E

3 J, l3 c% A( T) W. c& u

3 J, l3 c% A( T) W. c& u

这意味着模型生成的文本更加干净、准确,对于作为LLM训练数据的清洗流水线来说,价值巨大。& |( ~" e2 ^6 x% \8 S/ `

迈向真正的多模态统一 l+ V( p, [$ g8 h

DeepSeek在论文最后提到,DeepSeek-OCR2通过DeepEncoder V2验证了「LLM作为视觉编码器」的可行性。

$ C4 o9 K) t9 j* ~; X2 A这不仅是一个OCR模型的升级,更是迈向原生多模态(Native Multimodality)的重要一步。

0 R! Y+ V1 R. k3 ~ e* G& a7 Q! e) V未来,同一个编码器只要配备不同的模态查询嵌入(Query Embeddings),就能处理文本、图片、音频等多种模态的数据,真正实现万物皆可Token,万物皆可因果推理。2 e) z; a$ D- t4 h) C$ s/ ]

DeepSeek表示,虽然目前光学文本识别(OCR)是LLM时代最实用的视觉任务之一,但这只是视觉理解宏大图景的一小部分。

6 P/ i: e8 g( m ]* jDeepSeek将继续探索,向着更通用的多模态智能进发。 |

|