|

|

金磊 发自 凹非寺$ W. E5 `8 j0 u

量子位 | 公众号 QbitAI9 [4 f- f4 @1 `( p: y- B

2 X# z; {" M j2 H: @

不得了,机器人现在开始学会脑补未来了。: U1 ~( m, C5 @$ L+ _

这就是蚂蚁灵波又又又又(连续第4天)开源的狠活儿——4 i- O1 L# T% t8 b

全球首个用于通用机器人控制的因果视频-动作世界模型,LingBot-VA1 [3 @5 N. f, n, V! l3 F9 ?. [

3 f$ e# ~2 k5 |1 {0 h9 d2 u; X }( | B7 E7 k+ \7 W

. L- ?: ~6 d7 c0 \: P* p! m怎么个脑补法?

! b& r5 N. [* J; Z3 Y! x简单来说啊,以前的机器人(尤其是基于VLA的)干活儿,主打一个条件反射:眼睛看到什么,手立刻就动一下。

: {9 o0 O1 |/ O W4 M. Y7 _这叫“观察-反应”模式。/ L+ R( ~% H y/ P L

但LingBot-VA就不一样了,它通过自回归视频预测打破了这种思考方式,在动手之前,脑子里先把未来几秒的画面推演出来。

) @% I6 B8 k, b0 U$ l! r% @" g说实话,用想象力做决策,在机器人控制这块还是相当新鲜的。: ~6 |. E, j% }4 n! a

但这不是LingBot-VA唯一的亮点,还包括:

, X6 \- @; @- l. E( b) d* o$ W$ B

4 Q/ O1 a# m8 L( N

- 记忆不丢失:做长序列任务(比如做早餐)时,它会记得自己刚才干了什么,状态感知极强。( |0 J1 q. t8 v( \* S* c4 }* k' i

- 高效泛化:只要给几十个演示样本,它就能适应新任务;换个机器人本体,也能hold住。& S, B$ X$ G7 E9 c" c! n

/ D1 S) ~3 e# {: H

* i# D, d0 s j: m# \( @

1 x! V6 q+ {8 c+ a4 u- V) S

+ x7 V, j+ q4 ?9 X8 |( u4 e因此在LingBot-VA的加持下,像清洗细小的透明试管这种高精度任务,机器人已经是可以轻松拿捏:/ j1 L3 P: k9 o/ F/ I

- j8 |8 R. B- h* I% I5 P

- j8 |8 R. B- h* I% I5 P

% J2 Z& Y6 a. @( R9 W g v

4 i8 N8 L% B! K$ c5 h6 s

视频地址:https://mp.wEIxin.qq.com/s/xqE6C72usddKMc4EH89myA

7 n( p8 I! w& N3 n) { |! w8 C正如我们刚才提到的,今天是蚂蚁灵波连续第四天开源。) l2 F" o7 a& x2 e

如果说前几天的开源是给机器人加强了眼睛(LingBot-Depth)、大脑(LingBot-VLA)和世界模拟器(LingBot-World),那么今天的LingBot-VA,就是让这具躯壳真正拥有了灵魂

5 _& k2 c/ M A# E" \: y' R0 Y一个行动中的世界模型,让想象真正落到执行层面。6 q! X( c' r/ d6 h

如此一来,通用机器人的天花板,算是被蚂蚁灵波往上顶了一截。

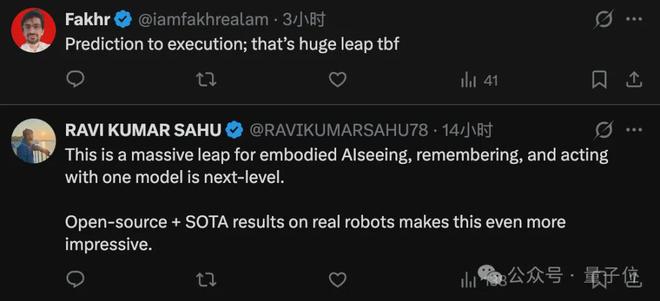

7 Z# H! ^5 D) I% x1 O) y正如网友所述:

6 W$ j t& m2 J9 N* l {

( M( @ r6 l2 [" K) ~/ z; {- N' J$ R' o

9 \. e) K* u# m6 v7 F& L$ p3 q

- 从预测到执行;说实话这是巨大的飞跃。

+ d) Q* b% E7 t 0 L& W1 v: ~8 q& I. j2 Q

) k- _# D4 z5 w, A9 c

" g$ f' x1 E! n3 p2 m5 X3 J

' p) H: _% \/ K/ q+ y2 w/ ]$ p

8 L* L: B3 y5 m: A0 A让想象力先行一步" E& z0 _% v$ o0 T( m m$ z6 n

3 c6 b6 D, t, p$ Q3 `0 l1 P6 {0 D

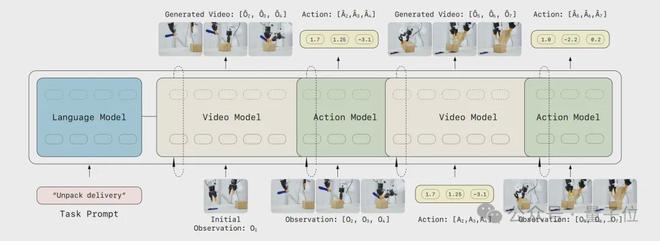

" x! J5 w( j! H E7 `LingBot-VA在架构设计上选择了一条更进一步的路径。

3 V- k, x& m# X4 {( v! r在传统的VLA(视觉-语言-动作)范式中,模型通常会将视觉理解、物理变化推理、低层动作控制这三项复杂任务放在同一个神经网络中处理,这在学术界被称为表征缠绕(Representation Entanglement)。! G8 h( |; ]# H4 s9 c! C3 B) f: h! T

为了追求更高的样本效率和更强的泛化能力,LingBot-VA选择把这团乱麻解开,提出了一套全新的解题思路:先想象世界,再反推动作。

' c8 i6 s, k# T# X% a( `& n为了实现这个想法,蚂蚁灵波团队采用了一个两步走的策略:, \9 n: i! l/ O: H b- T K' b

7 N2 _' A/ G9 F) ~! o! P; [, f0 t& L6 f

- 视频世界模型:先预测未来的视觉状态(接下来会发生什么)。

- \/ Z' l( T( G2 b8 K# w/ b - 逆向动力学(Inverse Dynamics):基于视觉的变化,反推出应该执行什么动作(为了达到这个画面,手该怎么动)。 Q- _% U a g+ z

. k+ F# S0 l4 S这与传统VLA有着本质区别:它不直接从“现在”跳到“动作”,而是要经过一下“未来”这个步骤。% }9 r6 N' U' ~$ }3 [

如何实现?蚂蚁灵波团队主要将三个架构层面作为突破口。& c. {% e( t# g6 R+ s

( \- r" s8 `0 P9 R5 s7 F0 K

( \- r" s8 `0 P9 R5 s7 F0 K

( q+ A6 A' U* t8 O

1 Z( \. z- D7 o" ?# ^3 g首先就是视频与动作的自回归交错序列

0 T a6 P: D: O8 i5 _在LingBot-VA的模型里,视频Token和动作Token被放进了同一条时间序列里。

# a6 k- {& U( ?9 }& o7 b& b为了保证逻辑严密,团队引入了因果注意力(Causal Attention)。这就像给模型定了一条死规矩:只能用过去的信息,绝对不能偷看未来。7 f( @4 Q5 x7 K+ k& |

同时,借助KV-cache技术,模型拥有了超强的长期记忆。它清楚地知道自己三步之前做了什么,任务绝对不会失忆。. ~ A9 C+ C4 t1 @

' m8 k, N/ ^$ S

' m8 k, N/ ^$ S

( c; \- G+ ?! w2 a8 d

3 C g% [" ]( D; D6 m

其次是Mixture-of-Transformers (MoT) 的分工协作: x" B/ \2 S) d" L/ p7 Y

这一步主要是为了解决我们前面提到的表征缠绕的问题。* g0 I$ P- j w" q. I) r4 D

我们可以把过程理解为“左右互搏”,但又很默契的一种配合:

7 l2 L, q' T- S+ H- X8 d

5 T4 i: _* T+ V

5 d! n2 M4 `/ o4 a- 视频流:宽而深,负责繁重的视觉推演。

5 F) M! c$ T0 A& ?7 } - 动作流:轻而快,负责精准的运动控制。

4 f4 L1 E/ Q" Z% B# A! t

0 S2 ^8 t9 d( V' \) @7 L这两个流共享注意力机制,信息互通,但在各自的表征空间里保持独立。9 b, V0 I$ t$ c) U0 ]' N3 A( i

这样一来,视觉的复杂性不会干扰动作的精准度,动作的简单性也不会拉低视觉的丰富度。

/ ^, u' [1 |: ]: v# M最后就是工程设计相关的工作。& G+ P$ `7 [; \* O! x$ v) i

毕竟光有理论是不好使的,“实践才是检验真理的唯一标准”: l5 d# E5 X) T% [; H

# g+ d6 L \7 B! g9 b/ f

- h+ {' s* {5 r$ h

- 部分去噪(Partial Denoising):做动作预测时,其实不需要每一次都把未来画面渲染得高清无码。模型学会了从带有噪点的中间状态里提取关键信息,计算效率大大提升。

' W. k! z6 R% g$ V* a9 | - 异步推理(Asynchronous Inference):机器人在执行当前动作的时候,模型已经在后台疯狂计算下一步了。推理和执行并行,延迟感几乎消失。

( Q! o$ B: [; r/ x - FDM 接地(Grounding):为了防止模型想象力脱离现实,系统会用真实的观测数据不断校正想象,避免出现开放式的幻觉漂移。9 V$ f7 D7 k! H( f, I+ l

实验结果与能力验证

5 j% G: n9 o' A. M2 V9 M3 V8 I/ P3 E

- L, P+ Q7 X+ k7 S' J! {3 k, u3 d. C8 d2 h" k2 O r1 K

在了解完理论之后,我们再来看实验效果。

7 h+ L0 R- C' x6 h5 D/ j0 B1 A蚂蚁灵波团队在真机实验和仿真基准上,对LingBot-VA进行了全方位的实测。% o0 L% h) c M/ E4 d% @( K k2 u2 i5 k

在真机测试中,LingBot-VA覆盖了三类最具挑战性的任务。' [9 _! o) [5 Q+ z$ n

首先是长时序任务,比如准备早餐(烤面包、倒水、摆盘)、拆快递(拿刀、划箱、开盖)。

* h! d2 N) P/ y; k

2 |7 G8 p, a# e, Y& |$ H; C

, H, M$ E! x5 O

1 R" x% p& Y% }; O m& n: q视频地址:https://mp.weixin.qq.com/s/xqE6C72usddKMc4EH89myA

a' L* ~7 i! [1 l7 J这些任务步骤繁多,但凡中间有一步有误,那可以说是满盘皆输。从LingBot-VA的表现来看,一个字,+ g6 M0 k9 ?3 P

即便是不小心失败了,机器人也会记得进度,尝试重来。

" P1 O# _1 D+ _5 P- a2 ^第二类是高精度任务,比如擦试管、拧螺丝。* U: C% {) C. p- Y& j

) Z* }& Q$ G5 W X5 d1 f/ X ^( u- w; h% M g$ i0 u

9 a3 {; y! a# N2 [& |! v1 A- Z( X视频地址:https://mp.weixin.qq.com/s/xqE6C72usddKMc4EH89myA

7 }) Y3 D# }) v这要求动作精度达到毫米级,得益于MoT架构,动作流不再受视觉噪声的干扰,手极稳。

5 J% x) k. Z5 j9 @2 \# l刚才我们已经看了擦拭管的案例,再来看个拧螺丝的:5 x3 b1 L2 F: s) |" `

第三类任务是针对可变形物体,例如折衣服、折裤子。* B" s$ f. b. F) h5 }

2 } k) v3 Y# x: v9 _

2 } k) v3 Y# x: v9 _

$ Z1 o8 Y6 P; c1 R" Y* k

$ t6 k W# w1 f: Q7 O视频地址:https://mp.weixin.qq.com/s/xqE6C72usddKMc4EH89myA

3 R: M* ^& J# `1 o& T1 Z% J4 g这些任务的难点在于物体处于一个随时变化的状态,但LingBot-VA通过视频推演,预判了布料的形变,操作行云流水。6 X# I9 F2 I9 s" ?% ~

除此之外,LingBot-VA在RoboTwin 2.0和LIBERO这两个硬核仿真基准上,也是很能打的。7 B* [- b. D! @

尤其是在RoboTwin 2.0的双臂协作任务中,无论是简单的固定场景(Easy),还是复杂的随机场景(Hard),LingBot-VA都展现出了不错的实力:: t B, D5 S0 [ |. f4 z

" @$ S# L2 }# [% Q1 S& W" ^7 I

# p4 O- X! U8 m- RoboTwin 2.0 (Easy):成功率92.93%,比第二名高出4.2%。& J" ]5 d. K: v& [$ J/ @& H

- RoboTwin 2.0 (Hard):成功率91.55%,比第二名高出4.6%。, i( v3 f8 _$ i

; L H! w8 @4 G. g( W) f

0 z& M! r* g; V- K5 l

9 j( M- u% ^: a6 s9 j

, w: M( _% U" _" t而且有一个趋势非常明显:

% n" w. L f h: y9 D% K任务越难、序列越长(Horizon变大),LingBot-VA的领先优势就越大。1 |( C( i# D* K* m& A& m

在 Horizon=3 的长任务中,它的优势甚至扩大到了9%以上。

r) Q! J' L& t' l而在LIBERO基准测试中,LingBot-VA更是拿下了98.5%的平均成功率,刷新了SOTA记录。( R; f$ f+ W! z2 p

7 y) k' q' u/ I* K9 U- }1 L1 X# C/ x+ [' W9 {

* a+ e J" w0 a. L) w总结一下,通过这些实验,我们可以清晰地看到LingBot-VA的三个核心特质:( d- O/ U' k l+ b( d

# Y+ n" C2 _/ @1 ~& q Q* I

8 J) `) J/ g9 I3 w- 长期记忆:在一个来回擦盘子的计数任务中,普通VLA模型擦着擦着就忘了擦了几下,开始乱擦;LingBot-VA 则精准计数,擦完即停。这就是KV-cache的起到的作用。

, { w, @; M- @- _4 E7 M6 Q/ s% n - 少样本适应:面对全新的任务,只需提供50条左右的演示数据,稍微微调一下,它就能学会。这比那些动辄需要成千上万条数据的模型,效率高了几个数量级。& N# Q( g3 ^% \0 O

- 泛化能力:训练时用的是某种杯子,测试时换个形状、换个颜色,或者把杯子随便摆个位置,它依然能准确识别并操作。+ M$ {- M$ A0 Y B2 A# C+ n

0 P4 t% L3 m' A' s& }2 n

2 [! e" ?$ o, M* U; x

2 [! e" ?$ o, M* U; x

1 x, Q6 y6 U; L5 P. \. a

0 D" D, j* F9 d* R, E [3 w- y9 N+ _) B' g

连续四天开源,已经产生影响

: V7 e3 D- i' j" a& }1 }+ M* ?6 E$ q. m: q" P

( Z0 W( U: d0 J把时间轴拉长,回看这四天的连续开源,我们会发现蚂蚁灵波下了一盘大棋。8 O+ g g0 {. F1 |

因为这四个开源项目拼凑在一起,就会形成一条非常清晰的技术主线:$ ~6 y6 @( o9 \" {4 Y0 H' Y" ?

- I/ Z5 X5 _2 Z/ i: ]8 p( [. q' X

, W( k2 J8 u+ O7 E7 }6 d3 ?7 v

- Day 1: LingBot-Depth——解决“看清”的问题。让感知能够更加清晰。

) C7 j" g! L! @( r7 t+ N - Day 2: LingBot-VLA——解决“连接”的问题。打通语言、视觉到动作的通用接口。" V! o" n" ^" |2 c$ d( M

- Day 3: LingBot-World——解决“理解”的问题。构建可预测、可想象的世界模型。1 y$ S9 k& w- G' \$ p2 b- u

- Day 4: LingBot-VA——解决“行动”的问题。把世界模型真正嵌入控制闭环,让想象指导行动。

# }/ ^2 C% S) u

7 M9 Z7 y/ w$ n( }% V这四块拼图凑在一起,释放了一个强烈的信号:

0 s. T r# A* T3 U0 E通用机器人正在全面走向视频时代。

1 a+ ?0 ^7 L+ |, @ y+ m视频,不再仅仅是训练用的数据素材,它正在成为推理的媒介,成为连接感知、记忆、物理和行动的统一表征。

0 G# _% ^) w5 S/ u; R* v4 K, X( j( r这对于整个行业来说,价值是巨大的。6 N0 Y+ b" W. v

对通用机器人来说,长任务、复杂场景、非结构化环境,这些曾经的硬伤,现在有了系统性的解法。$ j# a" T8 G0 S8 }

从具身智能路线来看,世界模型不再是一个可选项,它正式成为了机器人的中枢能力,从“能动”进化到“会想再动”。7 W+ Z4 x0 w: i6 X7 d! [

并且蚂蚁灵波的持续不断地开源动作,不仅仅是提供了代码、模型这么简单,更是一条可复现、可扩展的技术范式。

2 }1 e& k' e# y- j4 J7 y8 w. ^而蝴蝶效应也在行业中开始显现。# I$ _. f! {4 |$ ~' d" t9 B

就在这两天,谷歌宣布通过Project Genie项目让更多人体验Genie 3;宇树科技宣布开源UnifoLM-VLA-0……9 N5 G+ c" i \8 t

海外媒体也对蚂蚁灵波的开源动作有了不小关注,点评道:; a. y5 _ e5 r, G" Y% n" Q

I& H- |7 k6 w% F4 U

- x/ U" {* @3 b; [. Z. b6 n) Q6 `" L% [) T, P

- 蚂蚁集团发布了名为LingBot-World的高质量机器人AI模拟环境。这家中国金融科技公司完善了一套完整的开源工具包,用于物理AI系统的开发。这也是在全球机器人领域主导权争夺战中的一项战略性举措。* N4 S5 ~& I) U; y* t5 ?- o* O

$ r+ T ^$ z6 _4 Q# h' c( [

" `2 J$ f; h# O3 R7 Y

F; c1 w* r, [6 B) g9 N1 t. ^: ]4 W' B

嗯,蚂蚁灵波的压力是给到位了。

7 D$ p2 E3 m0 I0 l3 \0 x8 L1 l! ?总而言之,LingBot-VA的出现,标志着世界模型第一次真正站上了机器人控制的主舞台。" Z3 _5 n9 M% P2 c% Z0 o

项目地址:. a: [9 z, l) }8 L2 I$ z4 K7 g

https://technology.robbyant.com/lingbot-va

) L' s% y8 B# N. NGitHub地址:$ F. D2 S% `, W6 U2 Y6 o) d

https://github.com/robbyant/lingbot-va+ Y+ |+ k( U, P7 A5 @3 n

项目权重:

! B" u- r6 Q( I" c8 }; W, Shttps://huggingface.co/robbyant/lingbot-va. W8 C! a3 j' Z0 {; |5 O" d

https://www.modelscope.cn/collections/Robbyant/LingBot-va |

|